Les données sont le moteur de toutes les entreprises. D’ici 2024, nous consommerons 149 ZetaBytes de données dans le monde. Pour que vous puissiez comprendre l’importance de ce chiffre, il correspond mathématiquement à 10247 octets. Cette explosion de données est fortement attribuée à la numérisation rapide de la planète. L’analyse des données n’est pas nouvelle. Mais la méthode est nouvelle.

Les gens ont toujours analysé les données d’une manière ou d’une autre. Mais les humains ne sont pas aussi efficaces que les ordinateurs pour traiter les données volumineuses. Les machines n’ont pas encore dépassé l’intelligence humaine, mais elles nous ont surpassés en termes d’efficacité. La science des données et l’apprentissage automatique tirent parti du big data pour prendre des décisions commerciales intelligentes plus précises et validées.

Mais où se trouvent ces données ? Vous pouvez les trouver sur votre site web, ainsi que sur d’autres sites web et applications, des entreprises portales, des plateformes de médias sociaux, des senseurs IoT, etc.

Comment accéder à ces données ? La plupart des données accessibles au public peuvent être extraites, soit manuellement (ce qui n’est pas recommandé), soit de manière automatisée (ce qui est recommandé, voir les détails dans les sections suivantes). D’après votre cas d’utilisation, vous pouvez également acheter des données à des tiers (mais cela peut s’avérer coûteux, sans compter que vous n’avez aucun contrôle sur la qualité des données).

Par exemple,

– Si vous travaillez dans le secteur des produits de grande consommation et que vous avez besoin de données sur les produits, vous pouvez récupérer les sites Web de e-commerce ou les sites Web en ligne et les magasins de e-commerce de vos concurrents pour obtenir des données utiles.

– Si vous êtes dans le secteur des voyages et de l’hôtellerie et que vous avez besoin de données sur les restaurants, les hôtels et les locations, vous pouvez récupérer des données sur Google Maps, TripAdvisor, Booking.com et plusieurs autres sites en fonction de vos besoins.

– Pour la recherche et d’autres besoins, vous pouvez gratter des sites d’actualités, des sites gouvernementaux et des sites d’agrégation de documents de recherche scientifique.

– Si vous avez besoin de données relatives aux emplois, vous pouvez scraper indeed.com, naukri.com, linkedin.com ou d’autres sites Web appropriés.

Cet article se concentre uniquement sur les outils et techniques de scraping web. Maintenant que nous avons expliqué où se trouvent les données et comment accéder à des échantillons de données, voyons pourquoi le scraping automatisé doit être préféré au scraping manuel.

Pourquoi devriez-vous choisir le scraping automatisé plutôt que manuel?

Vous pouvez collecter des données sur les sites Web de deux manières :

1. En employant des humains pour la collecte de données, c’est-à-dire en procédant à une collecte manuelle.

2. Employer des bots (programmes informatiques) pour collecter les données et les enregistrer dans des fichiers JSON, des feuilles de calcul ou des documents bruts.

Le scraping manuel de sites Web est le moyen le plus simple de commencer l’extraction de données. Mais nous ne la recommandons pas pour n’importe quelle tâche de scraping. Cette méthode ne doit être privilégiée que si vos besoins en données sont trop faibles. Par exemple, vous n’avez besoin de données que sur 10 produits et une seule fois. Pour tout ce qui est supérieur à cela, le raclage automatisé par robot s’avérera beaucoup plus efficace et vous permettra d’économiser du temps, de l’argent et des ressources.

Comment fait-on pour scraper des données ?

Il vous suffit de pointer votre curseur sur les données cibles, de les sélectionner et de les copier/coller dans votre base de données cible.

Quel est le désavantage de l’extraction manuelle de données ?

– C’est sacrément lent. Oui, plus lent que les paresseux à trois doigts

– C’est coûteux, car les humains coûtent cher

– C’est sujet à des erreurs déclenchées par l’homme

– Ce n’est pas évolutif. Techniquement, elle l’est, mais cela signifierait dépenser des millions de dollars pour quelque chose qui peut être réalisé en dépensant seulement quelques centaines ou milliers

Comment réaliser le scraping automatisé d’un site web ?

Il y a deux façons d’effectuer le scraping automatisé de sites Web :

1. En utilisant des outils de Web Scraping

2. En utilisant des scripts personnalisés pour automatiser l’extraction de données

Scraping de Web Sites à l’aide d’outils de scraping

Il existe des outils, que j’appellerais des navigateurs intelligents, auxquels on peut apprendre à imiter des actions humaines répétitives. Une fois que vous leur avez appris à effectuer certaines actions, ils peuvent répéter la tâche un nombre illimité de fois.

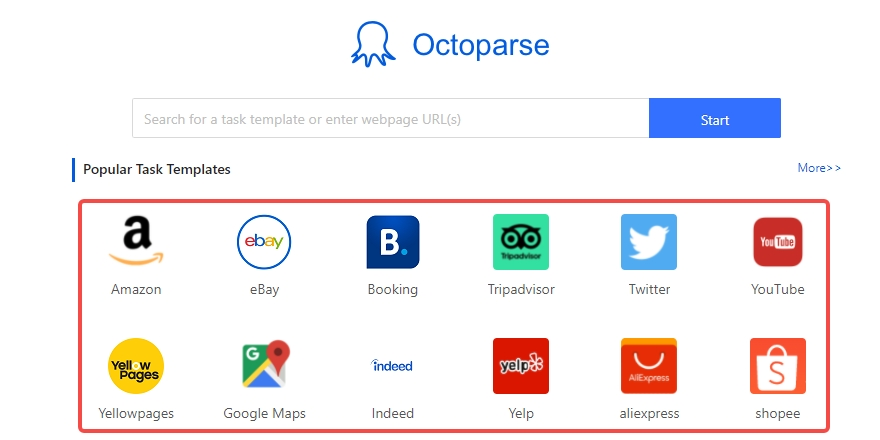

Octoparse est l’un de ces outils intelligents de scraping web. Les meilleurs de ces outils de scraping Web sont intuitifs. Vous les utilisez comme vous le feriez avec un navigateur Web normal. La seule différence est qu’ici, vous apprenez au navigateur à extraire les données qui vous intéressent. Nous avons montré une démonstration vers la fin de cet aperçu. Vous n’avez pas besoin de savoir coder pour utiliser des outils de scraping web comme Octoparse. Mais il est utile de connaître les Xpaths et les expressions régulières (regEx).

Quels sont les avantages de l’utilisation d’outils de Web scraping pour extraire et sauvegarder des données de sites Web ?

- Facile à utiliser, cliquer et extraire. Ces outils ont une courbe d’apprentissage quasi nulle ou très faible. Si vous savez “comment cliquer sur les boutons de la souris, vous pouvez commencer à utiliser les outils de scraping web”

- Hautement évolutifs, vous pouvez extraire des millions de données à une vitesse fulgurante

- Rentable, car les robots sont mis à contribution. Les coûts engendrés par l’utilisation d’outils de scraping web sont exponentiellement inférieurs à ceux du scraping manuel

- Traitement automatique des architectures de sites Web anti-scraping. De nombreux outils de scraping sont dotés de mécanismes permettant de contourner les architectures anti-bots telles que les captchas, les empreintes digitales des sites Web et les interdictions de robots liées aux cookies

- Vous permet d’extraire des données dans le format de votre choix : JSON, .xls, etc., ou vers les bases de données de votre choix (MongoDB, MySQL, etc.)

- Vous permet de programmer et d’extraire périodiquement des données de sites Web

- Vous pouvez également extraire des données dans le Cloud et augmenter vos ressources ou les libérer lorsqu’elles ne sont pas nécessaires

Pourquoi ne pas utiliser des outils de scraping web “click and extract” ?

- Si vos besoins en matière de données sont très faibles, c’est-à-dire si vous n’avez besoin de récupérer qu’une ou deux pages

- Si votre site Web source est très peu structuré, c’est-à-dire s’il présente des modèles variés

Scraping de sites Web à l’aide de Scripts Customisés

Cela ressemble beaucoup à l’utilisation d’outils de web scraping. Mais contrairement à ces derniers, vous n’avez pas à cliquer et à extraire les données. Au lieu de cela, vous écrivez un robot en utilisant le langage de script de votre choix – Python, nodeJS, PHP, Java, etc. et vous imitez les interactions humaines avec le site Web. Ensuite, vous exécutez les scripts localement sur votre système ou dans le Cloud pour extraire les données.

Quels sont les avantages du scraping de sites web à l’aide de scripts personnalisés ?

– Extrêmement évolutif

– Hautement personnalisable

– Rentable pour le scrapping à grande échelle

– Peut être programmé pour effectuer des scrappings périodiques

Pourquoi ne pas scrapper le web en utilisant des scripts personnalisés ?

– Lorsque la source de données est hautement structurée. Les outils de scraping web sont à privilégier car ils vous permettent de démarrer relativement rapidement.

– Vaste courbe d’apprentissage

– Les ingénieurs en automatisation ont un salaire élevé, que vous devez payer.

– Vous devez gérer vous-même les techniques anti-scraping. Cela représente parfois des frais généraux considérables.

– Vous devez écrire des scripts pour stocker les données dans la base de données

Comment récupérer des données à partir de n’importe quel site web ?

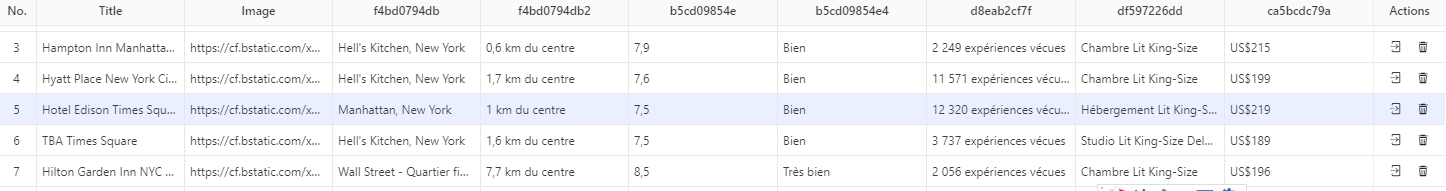

Maintenant, nous allons démontrer le scraping de Booking.com en utilisant Octoparse. Cela vous sera utile pour créer des sites Web d’agrégateurs d’hôtels ou pour concevoir la bonne stratégie de tarification pour vos hôtels.

Si vous n’êtes pas encore un utilisateur d’Octoparse. Inscrivez-vous maintenant, c’est GRATUIT. Si vous êtes déjà inscrit, connectez-nous ici.

Le scraping avec Octoparse se fait en quatre étapes seulement:

1. Entrer URL – Ouvrir la page web cible

2. Auto-détection de la page Web – création d’un flux de travail

3.Cliquez sur le lien de l’image – récupérez les informations de la page de détails

4.Lancer l’extraction – exécuter la tâche et obtenir les données

Vous pouvez consulter un tutoriel détaillé ici : Scraper les informations sur les hôtels de Booking

Octoparse est l’outil idéal pour répondre à tous vos besoins en matière de scraping. Vous pouvez créer des flux de travail qui alimentent votre pipeline ETL avec des données hautement structurées. Avec Octoparse, vous pouvez:

- Utiliser des modèles pré-construits pour scrapper des sites web populaires comme Amazon, Indeed, etc

- Construire des API et les utiliser dans votre application

- Préparer des workflows personnalisés pour scraper des sites web complexes

- Stockez les données dans XLS JSON, HTML, CSV ou dans votre base de données

- Scraper dans le Cloud

发表回复