Il arrive toujours qu’on a besoin d’une longue liste d’URLs. Quand le copier-coller semble trop ennuyant, j’écris ce guide rapide pour vous aider à extraire toutes les URLs d’une page web vers Excel avec Octoparse. Allons voir si Octoparse est l’extracteur d’URLs que vous recherchez.

Pourquoi URL extractor ?

Je ne sais pas si vous ayez une idée de ce qu’est un article récapitulatif. Mais vous devez en avoir lu quelques-uns, et très probablement, vous avez capturé quelque chose que vous voulez sauvegarder pour l’utilisation ultérieure.

Prenons l’exemple des 100 sites de soumission d’infographies. Si je suis un spécialiste du référencement et qu’un jour je tombe sur cet article, ce qui me viendrait à l’esprit serait du genre :

“Regardez ça. Je peux mettre les URLs de ces sites Web dans un tableau et, chaque fois que je crée une nouvelle infographie, je la soumets à ces sites. Cela pourrait définitivement aider à augmenter le trafic de mon site web ou au moins le nombre de backlinks.”

Oui, extraire une liste d’URLs dans un tableau, c’est ce que l’extracteur d’URL peut faire. Vous pouvez utiliser des outils de web scraping, des extensions de navigateur ou même écrire des scripts pour ce faire. Cet article énumère justement les 10 meilleurs extracteurs de lien à ne pas manquer.

Dans la partie suivante, je vais extraire des URLs avec Octoparse, qui est un outil de web scraping, en quelques secondes.

Extraire les URLs d’une page Web

Voici un exemple simple pour démonstrer comment extraire une liste d’URLs depuis une page Web et la exporter vers Excel. Si vous cherchez à gratter des données autres que des URLs, je vous recommande à consulter d’autres articles de blog d’Octoparse.

Préparations

- Télécharger Octoparse et l’installer dans votre ordinateur

- S’inscrire et se connecter

- Trouver la page web cible pour récupérer une liste d’URLs

En effet, un navigateur est intégré dans Octoparse. Lorsque vous entrez l’URL cible dans le logiciel, la page web se chargera comme dans un navigateur Chrome et vous pourrez la parcourir librement. La seule différence, c’est que vous pouvez cliquer sur des cléments et construire un scraper pour extraire les textes, les tableaux, les hiffres, les fichiers, etc.

Guide étape-par-étape

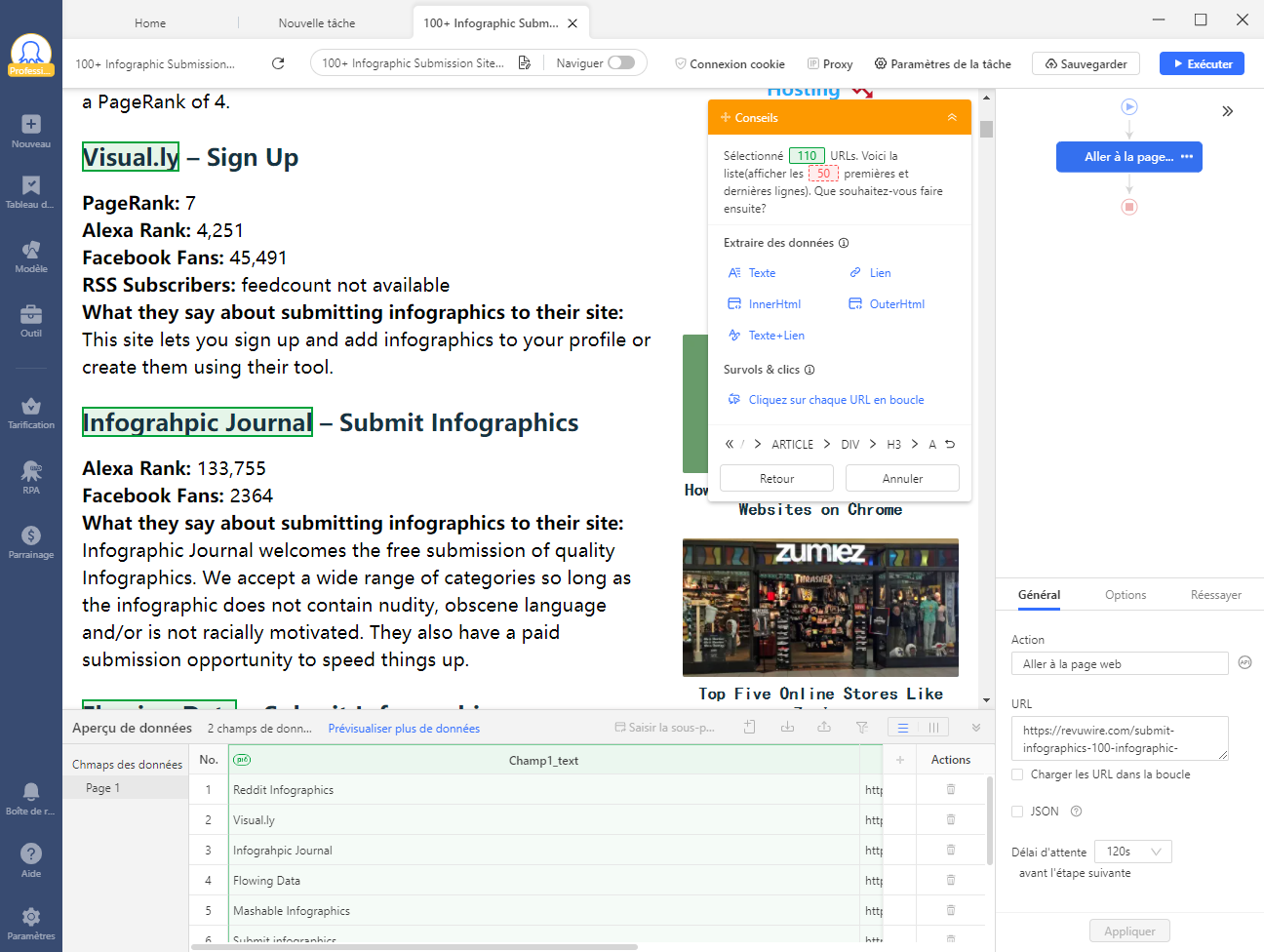

- Entrez l’URL cible dans Octoparse : Il faut que la page cible contient une liste bien structurée d’URLs. Si les hyperliens se dispersent avec des textes d’ancrage dans les paragraphes d’un article, il est difficile pour le robot d’Octoparse de les détecter à grande échelle.

Prenons-nous pour exemple cette page mentionnée plus tôt : https://revuwire.com/submit-infographics-100-infographic-submission-sites/

- Cliquez sur le premier hyperlien de la liste

- Cliquez sur le deuxième hyperlien de la liste

La liste complète des sites web d’infographie sera sélectionnée en vert, comme ce que montre la capture d’écran suivante.

- Cliquez “Texte + Lien” dans le panneau de conseil en haut à droite. Un flux de travail sera généré automatiquement à droite.

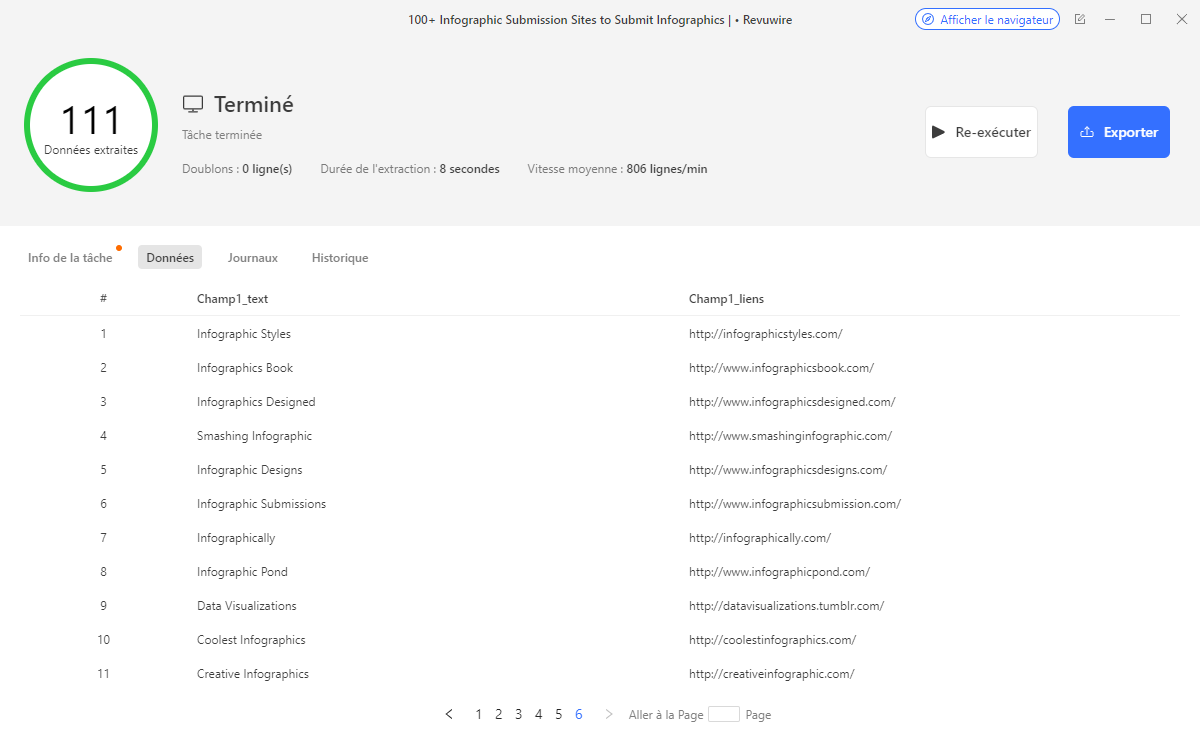

- Cliquez sur “Exécuter” et choisir d’exécuter sur votre appareil en mode standard. 8 secondes sont suffisantes pour extraire 111 liens.

Voilà, c’est fait.

Après quelques clics, vous avez réussi à créer votre propre extracteur d’URL, à le lancer pour récupérer une liste d’URLs.

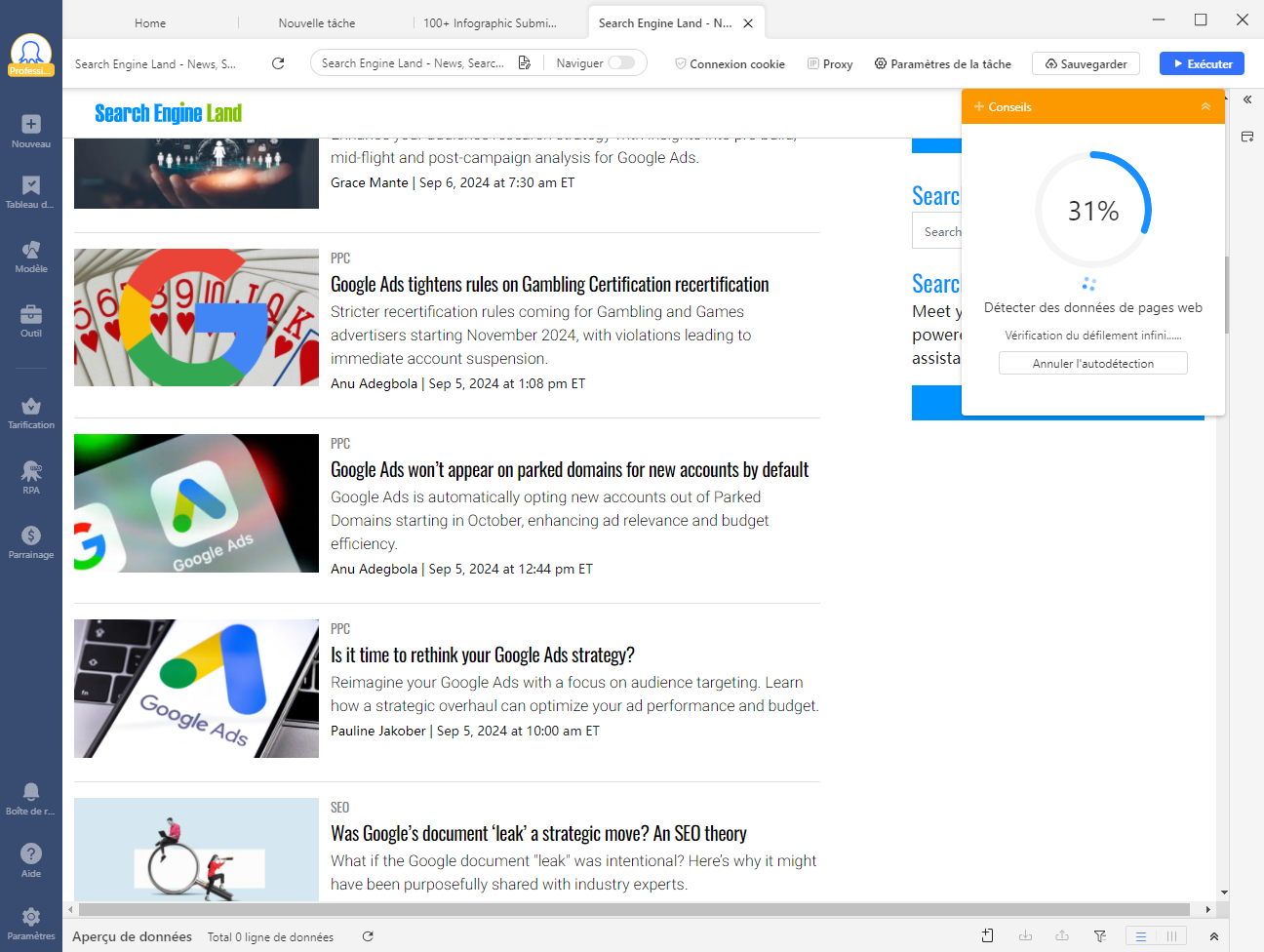

Utiliser Auto-détection

Si la page Web que vous allez scraper est d’une structure typique, vous pouvez opter pour la fonction d’auto-détection.

Si l’auto-détection marche, l’algorithme d’IA va sélectionner les données pour vous et il vous suffit de cliquer sur “Créer un flux de travail”. Cela est surtout utile pour ceux qui souhaitent scraper des sites d’annuaires, des sites d’e-commerce, des sites d’emploi, etc.

Améliorez votre efficacité au travail avec Octoparse !

Si vous êtes un spécialiste du marketing numérique et que vous n’ayez aucune idée du web scraping, voici une bonne occasion pour apprendre quelque chose de nouveau.

Pour moi, je travaille dans le marketing et j’utilise le plus souvent cet outil de scraping web pour collecter des données à un rythme que je ne pourrais jamais atteindre manuellement. Ce qui m’intéresse le plus comprend :

- Récupérer des articles et des nouvelles à propos de mon industrie

- Télécharger en masse les données des concurrents, pour se tenir informé en permanence

- Sauvegarder toujours des ressources précieuses vers Excel et en faire un plan de travail exploitable

Bien sûr, le web scraping est maintenant largement utilisé. En tant que outil pour récupérer un grand nombre de données en peu de temps, il apporte déjà de la croissance aux sociétés-conseillers, à l’e-commerce, à l’hôtellerie, à l’immobilier. Si vous y êtes intéressé, veuillez consulter d’autres articles pour découvrir comment le web scraping aide à améliorer votre efficacité de travail.

Transformer les sites web vers Excel, CSV, Google Sheets ou base de données.

Auto-détecter les sites Web et extraire les données sans aucun codage.

Scraper les sites populaires en quelques clics avec les modèles pré-construits.

Ne se trouver jamais bloqué grâce aux proxies IP et à l’API avancée.

Service Cloud pour programmer le scraping de données.

发表回复