Dans le monde numérique, les données sont générées d’une vitesse vertigineuse. Quand les gouvernements, les entreprises, les KOLs font voir des informations, les internautes se pressent de partager leurs propres idées sur des réseaux sociaux, des blogs, des forums ou des sites d’avis. Ce genre de sites est justement ce qu’on appelle sites web dynamiques. Jusque là, les entrepreneurs d’un sens aigu ont déjà compris les avantages d’utiliser les données de ces sites pour améliorer leur business.

L’article de blog donnera des idées sur comment rechercher du growth avec les données des sites Web dynamiques. J’espère qu’il peut vous expliquer bien pourquoi et comment extraire en temps réel les données des sites Web dynamiques.

C’est quoi, les sites Web dynamiques ?

Un site web dynamique est celui dont le contenu sont proposé sur demande. Contrairement à un site web statique, qui a un contenu prédéfini qui ne change pas, un site web dynamique utilise des technologies telles que des scripts côté serveur, des bases de données et des langages de programmation tels que PHP, Python ou Ruby pour générer et afficher du contenu personnalisé pour chaque utilisateur.

Les sites web dynamiques offrent de nombreuses fonctionnalités et avantages par rapport aux sites web statiques. Par exemple, ils permettent une interaction plus étroite entre le visiteur du site et le contenu, permettant ainsi une expérience utilisateur plus personnalisée. Ils sont également plus faciles à maintenir, car la plupart des mises à jour peuvent être effectuées en modifiant simplement le code côté serveur plutôt que de devoir modifier chaque page individuellement.

En outre, les sites web dynamiques sont souvent utilisés pour des applications Web plus complexes, telles que les réseaux sociaux, les applications de commerce électronique, les forums de discussion, les blogs, les sites de voyage et de réservation de billets, les sites d’actualités et bien plus encore.

Pourquoi tant d’entreprises sont intéressées par les données des sites Web dynamiques ?

Dans l’ère du big data, les entreprises qui attendent d’une croissance se préoccupent toutes de collecter le plus de données possible. En limitant les données à celles des sites Web dynamiques, je tente de surligner l’importance des données qui sont générées en temps réel. Et pourquoi les données immédiates sont importantes et comment elles poussent tant d’entreprises à extraire en temps réel les données des sites Web dynamiques ? Voilà des idées sur comment les entreprises profitent de ces données.

Prendre plus rapidement des décisions basées sur des données

En capturant les données dynamiques, vous disposez d’informations en temps réel sur les nouvelles tendances du marché et sur vos concurrents. Avec toutes ces informations actualisées à portée de main, vous pouvez réduire considérablement le délai entre la cause et l’effet. En d’autres termes, vous pouvez obtenir des informations fondées sur des données et prendre des décisions en fonction des données plus rapidement et plus facilement.

Comme l’a dit Jeff Bezos, PDG d’Amazon, dans une lettre aux actionnaires, “la vitesse compte dans les affaires”. La “prise de décision à grande vitesse” est d’une grande importance pour le développement des entreprises.

Construire une base de données plus puissante

Alors que le volume de données ne cesse de croître dans le monde numérique d’aujourd’hui, la valeur liée à chaque donnée a considérablement diminué. Pour améliorer la qualité de l’analyse des données et la validité des décisions, les entreprises doivent constituer une base de données complète et volumineuse en extrayant des données dynamiques en continu.

Les données sont un actif sensible au temps. Plus les informations sont anciennes, plus il est difficile de les collecter. Comme le nombre d’informations augmente chaque année en taille et en rapidité, il devient crucial, sans précédent, de garder la trace des données changeantes pour une analyse ultérieure.

D’une manière générale, la collecte de données à court terme permet de relever les problèmes récents et de prendre de petites décisions, tandis que la collecte de données à long terme peut vous aider à identifier les tendances et les modèles afin de fixer des objectifs commerciaux à long terme.

Mettre en place un système adaptatif et analytique

L’objectif ultime de l’analyse des données est de mettre en place un système d’analyse des données adaptatif et autonome, afin d’analyser les problèmes de manière continue. Il ne fait aucun doute qu’un système analytique adaptatif est basé sur la collecte automatique de données dynamiques. Dans ce cas, il permet de gagner du temps dans la construction de modèles analytiques à chaque fois et d’éliminer les facteurs humains dans la boucle. La conduite autonome des voitures est un excellent exemple de solution analytique adaptative.

Comment les données dynamiques promeuvent la croissance des entreprises ?

En effet, les données des sites web dynamiques, ce sont des informations actualisées sur les produits ou service, sur une industrie, sur les concurrents, sur les clients ou l’opinion publique. Donc les entreprises se soucient de les collecter pour y trouver de la valeur. D’autre part, les données les plus récentes disent les nouvelles tendances et les derniers besoins, lesquels sont essentiels pour le business qui recherchent l’innovation et la croissance. C’est pourquoi les données dynamiques importent dans le suivi des produits/concurrents/clients, et dans la prise de décision. Pour l’expliquer d’une façon plus détaillée, on peut utiliser les données dynamiques dans la fin de favoriser :

Suivi des produits

C’est le cas le plus fréquent parmi les entreprisent qui font le business en ligne et surtout sur des plateformes de commerce électronique. Les informations sur les produits, comme le prix, la description, les avis des clients et les images, sont toutes disponibles sur les marchés en ligne et mises à jour régulièrement. L’extraction d’informations dynamiques vous permet également d’évaluer la position concurrentielle des produits et de développer des stratégies de tarification et de stockage efficaces. Il peut s’agir d’une méthode fiable et efficace pour surveiller les actions des concurrents sur le marché.

Par exemple, une étude de marché préalable à la sortie d’un produit peut être réalisée facilement en récupérant les informations sur le produit sur Amazon ou d’autres sites.

Gestion de l’expérience client (CEM)

Surveiller en temps les feedbacks des utilisateurs

Les entreprises sont plus que jamais attentives à la gestion de l’expérience client. Selon la définition de Gartner, il s’agit de “la pratique consistant à concevoir et à réagir aux interactions avec les clients afin de satisfaire ou de dépasser leurs attentes, et donc d’accroître la satisfaction, la fidélité et la défense des clients.”

Par exemple, extraire les avis clients Amazon pour faire l’analyse de sentiment peut aider à déchiffrer le sentiment des clients sur le produit en analysant les commentaires positifs et négatifs. Cela permet de comprendre les besoins des clients et de connaître leur niveau de satisfaction en temps réel.

Stratégies de marketing

L’analyse des données dynamiques vous permet de savoir si la stratégie marketing actuelle fonctionne bien et quelles améliorations peuvent être apportées. L’extraction de données dynamiques vous permet d’évaluer le succès d’une stratégie marketing en temps réel et de procéder à des ajustements précis en conséquence. Dans ce cas, les acteurs font surtout attention aux réseaux sociaux ou des forums où les internautes partagent leurs expériences et opinion.

De quoi a-t-on besoin pour extraire en temps réel les données des sites dynamiques ?

S’agissant de la collection de données, ce qui vient premièrement à la tête est le web scraping. Au fur et à mesure que le concept de growthhacking devient populaire parmi les start-ups, la technique de web scraping est plus familier qu’avant aux entrepreneurs.

Le web scraping consiste à extraire les données des sites web et à les transformer en des données structurées. Il peut être facile et complexe en fonction des données et des sites web qu’il cible. Quant au scraping des sites web dynamiques pour y extraire des données en temps réel, j’ai conclu des points de fonctionnalités importants et incontournables. Il faut que l’outil de web scraping que vous choisissez ou que vos scripts de codes comprennent :

👉 Extraction Cloud

En lançant votre projet d’extraction de données sur le nuage, la tâche s’exécutera 24 heures sur 24, que vous allumiez ou non votre appareil ou quel que soit l’état de vos appareils locaux. Ainsi, vous n’avez plus besoin à vous asseoir à côté de votre ordiateur avant que la tâche ne soit terminée.

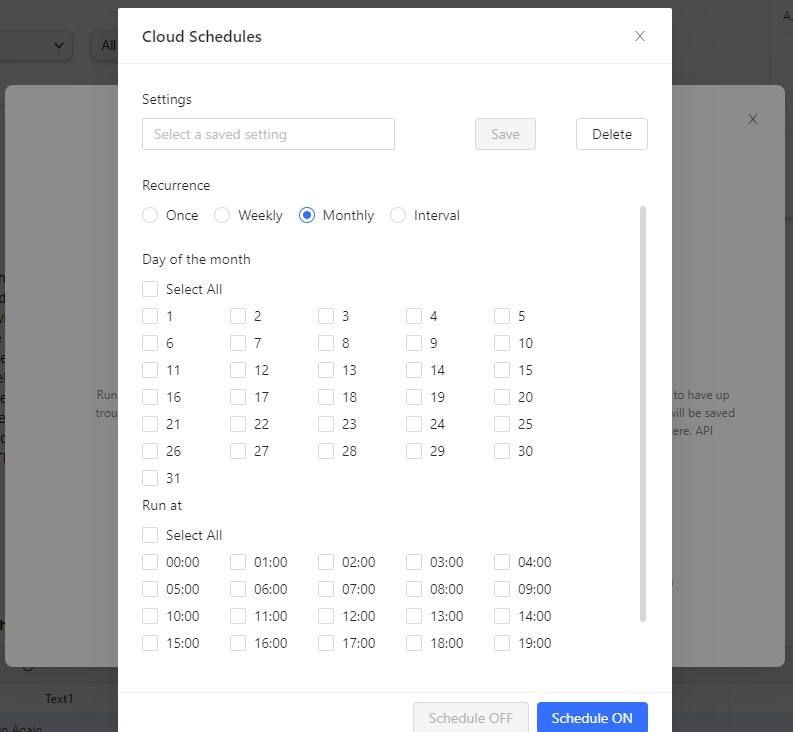

👉 Extraction plannifiée

Puisque notre but est de collecter les données mises à jour en temps réel, il faut extraire les données chaque minute ou chaque 10 secondes pour suivre de près les dernières informatiosn.

👉 Extraction incrémentale

C’est une fonction importante. L’extraction incrémentale, cela veut dire que le robot n’extrait que les données nouvellement générées tout en se passant des données déjà existantes dans l’extraction dernière. Grâce à l’extraction incrémentale, on s’échappe facilement à des données doublons, augmentant largement la productivité et l’efficacité.

👉 Extraction de données dernière connexion et AJAX

On sait que la caractéristique la plus importante des sites dynamiques est que les contenus affichés sur des pages Web varient sur demande. Connexion et AJAX sont deux éléments les plus utilisés pour cela. Donc, si vous souhaitez obtenir les données dynamiques, il faut que votre tâche de scraping est assez puissante pour régler AJAX et supporte l’extraction de données dernière connexion.

👉 API

Bien que les données du Cloud puissent être exportées automatiquement vers notre base de données, l’API permet d’améliorer considérablement la flexibilité des données exportées vers votre propre système.

Ce que vous devez savoir, c’est que l’API d’Octoparse est de deux types : API standard et API avancée. La première, dans le plan Standard, prend en charge la gestion des données. La seconde, dans le plan Professionnel, prend en charge la gestion des tâches et des données.

Je ne peux jamais tout mentionner. C’est à chacun de faire des pratiques, de découvrir des problèmes avant de trouver des réponses.

Un outil destiné au scraping de données dynamiques et un guide étape par étape

Mis à part le web scraping avec des scripts de codes, on veut parler plutôt du web scraping no-code dans cet article. Car ce dernier permet à chaun d’obtenir les données dont il a besoin sans avoir recours à des programmeur.

De nombreux outils de web scraping no-code sont accessibles sur le marché, parmi lesquels Octoparse, une solution tout-en-un pour la collection de données depuis des pages Web. Octoparse offre un service aux utilisateurs de tout niveau, de plus facile jusqu’au plus complexe, y compris l’extraction de données en temps réel depuis des sites Web dynamiques.

Voilà les étapes pour extraire les commentaires clients des produits toujours mis à jour depuis Amazon.

Étape 1 – configurer une tâche de web scraping

Je ne répèterai plus les étapes de configurer une nouvelle et je vous invite à consulter ce tutoriel

Scraper des commentaires sur des produits de Amazon | Centre d’Aide

Étape 2 – lancer le scraping sur Cloud et planifier l’extraction

Vous pouvez faire s’exécuter la tâche hebdomadairement, mensuellement, à tout moment, à n’importe quelle fréquence selon vos besoins et selon la vitesse d’apparition de nouvelles données sur ce site. Par exemple, pour extraire les avis clients des produits Amazon, je préfère que l’extraction s’exécute chaque semaine.

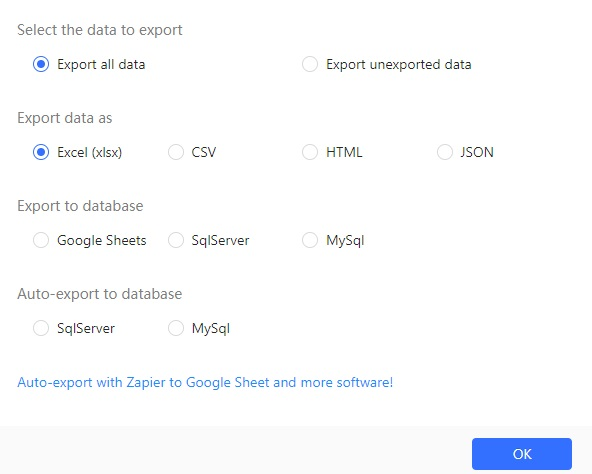

Étape 3 – extraire les données

Vous pouvez choisir d’extraire les données vers plusieurs formats ou veres des bases de données. API est également disponible.、

C’est bien ! Mais il faut faire attention que le service Cloud est une fonction exclue aux utilisateurs payants. A côté du service Cloud, les utilisateurs premium profitent également de téléchargement de fichiers, solveurs de CAPTCHA, proxies API et bien d’autres fonctionnalités intéressantes. En outre, avec un coût inférieur de 50 % par rapport aux services similaires du marché, c’est vraiment un outil de bon coût-efficacité, à partir de 75 $.

Extraire en temps réel les données des sites Web dynamiques met surtout en accent la rapidité de l’extraction de données. Les entreprises qui les saisissent peuvent prendre davantage de l’avance. Octoparse est un outil idéal pour y arriver. Ses fonctionnalités avancées, la vitesse d’extraction de données et la facilité de l’utiliser ont fait de ce logiciel un outil excellent pour extraire en temps réel les données des sites Web dynamiques.

Allez faire votre découverte et commencer à découvrir la valeur des données.

Bon scraping !

发表回复